گوگل بهتازگی از جدیدترین و قدرتمندترین مدل هوش مصنوعی خود به نام Gemini 2.5 Deep Thinkرونمایی کرده است. این مدل که پیشتر با کسب مدال طلا در المپیاد جهانی ریاضی (IMO) خبرساز شده بود، اکنون دردسترس است، اما نه برای همه. استفاده از آن فعلاً فقط برای مشترکین سرویس گرانقیمت Google AI Ultra با هزینهی ماهانه ۲۵۰ دلار ممکن است و با محدودیتها و هشدارهای مهمی هم همراه شده است.

به گزارش زومیت؛ قدرتمندترین هوش مصنوعی گوگل، روی تاریک و ناشناختهای هم دارد. در تابستان ۲۰۲۴، غول تکنولوژی هنگام آزمایشهای داخلی این مدل قدرتمند، بهطور عمومی تأیید کرد که جدیدترین ساختهاش، اگرچه هنوز به «نقطه بحرانی» نرسیده، در حال نزدیک شدن به قابلیتهایی است که میتواند به ابزاری خطرناک در دستان افراد نادرست تبدیل شود.

قدرتمندترین هوش مصنوعی گوگل، روی تاریک و ناشناختهای هم دارد

با ما همراه شوید تا به معماری یک «مدل متفکر» که میتواند آیندهی تکنولوژی را دگرگون کند، سفر کنیم و همزمان، نگاهی بیندازیم به چارچوبهای ایمنی پیچیدهای که برای مهار کردن هیولای هوش مصنوعی، طراحی شدهاند. آیا این چارچوبها کافی هستند؟ و آیا در رقابت نفسگیر برای ساخت هوش مصنوعی برتر، میتوان میان سرعت و مسئولیتپذیری، توازن برقرار کرد؟

از زنجیر تا درخت: تکامل تفکر در ماشین

برای درک اهمیت Deep Think، باید سفری کوتاه به تاریخچهی استدلال در هوش مصنوعی داشته باشیم. در ابتدا، مدلهای زبان بزرگ (LLM) مانند دانشآموزی کمحوصله عمل میکردند؛ یک سؤال میپرسیدید و آنها اولین پاسخی را که به ذهنشان میرسید، بدون هیچ توضیح اضافهای، بیرون میدادند.

نقطه عطف اول، تکنیکی به نام «زنجیره تفکر» (Chain-of-Thought) بود. این روش، مدل را وادار میکرد تا قبل از ارائه پاسخ نهایی، مراحل فکر کردنش را قدم به قدم بنویسد. این کار ساده، کیفیتی جهشی در پاسخها ایجاد کرد، زیرا مدل را مجبور به شکستن مسائل پیچیده به اجزای کوچکتر میکرد. اما این زنجیره یک ضعف بزرگ داشت: اگر یک حلقه در ابتدا اشتباه بود، کل زنجیره تا انتها اشتباه پیش میرفت و راهی برای بازگشت و اصلاح نبود.

برای حل این مشکل، تکنیک بعدی یعنی «درخت تفکر» (Tree-of-Thought) متولد شد. در این روش، مدل به جای دنبال کردن یک مسیر خطی، چندین مسیر استدلال را به طور همزمان مانند شاخههای یک درخت، کاوش میکند.

مدل میتواند در هر مرحله، چند «فکر» یا گام بعدی ممکن را تولید کند، هر مسیر را ارزیابی کند و در صورت نیاز به عقب بازگردد یا استراتژیهای جایگزین را امتحان کند. این فرآیند، جهشی از تفکر خطی به حل مسئله اکتشافی بود؛ شبیه به روشی که انسانها برای حل معماهایی که راهحل مستقیم ندارند، به کار میبرند.

معماری Deep Think: بودجهای برای تفکر

قابلیت «Deep Think» گام منطقی بعدی در این مسیر تکاملی است، اما با یک پیچیدگی بیشتر. این قابلیت، یک مدل مستقل نیست، بلکه یک «حالت ویژه» در مدل جمنای است که میتوان آن را فعال کرد.

با فعالسازی «Deep Think»، مدل به ابزارهایی مانند اجرای کد و جستجوی پیشرفته در گوگل مجهز میشود و مهمتر از آن، از یک معماری پیچیده بهره میبرد که سه عنصر کلیدی را ترکیب میکند: تفکر موازی (مانند درخت تفکر)، تولید فرضیه و خود-نقادی.

نوآوری اصلی در مفهومی به نام «بودجه تفکر» نهفته است

اما نوآوری اصلی «Deep Think» در مفهومی به نام «بودجه تفکر» (thinking budget) یا «محاسبات در زمان آزمون» نهفته است. این یعنی گوگل میتواند به مدل اجازه دهد قبل از ارائه پاسخ، مقدار بسیار بیشتری محاسبات داخلی انجام دهد.

به عبارت سادهتر، میتوان برای مسائل دشوارتر، «زمان تفکر» بیشتری خرید. این ویژگی، استدلال را از یک قابلیت ثابت به یک منبع مقیاسپذیر تبدیل میکند.

این صرفاً یک پیشرفت فنی نیست، بلکه یک استراتژی تجاری هوشمندانه است. گوگل با ارائه مدل ارزانتر و سریعتر (Gemini Flash) و یک مدل گرانتر و عمیقتر (Gemini Pro با Deep Think)، به مشتریان این امکان را میدهد که براساس نیاز خود، برای «تفکر» هزینه کنند.

این کار یک خندق رقابتی در برابر نرمافزارهای متنباز نیز ایجاد میکند. شاید دیگران بتوانند مدل پایه را کپی کنند، اما بازتولید یک سیستم یکپارچه با زیرساخت جهانی، صورتحساب و کنترلهای دقیق، بسیار دشوارتر است.

تحلیل عملکرد: یک نابغه پراشتباه

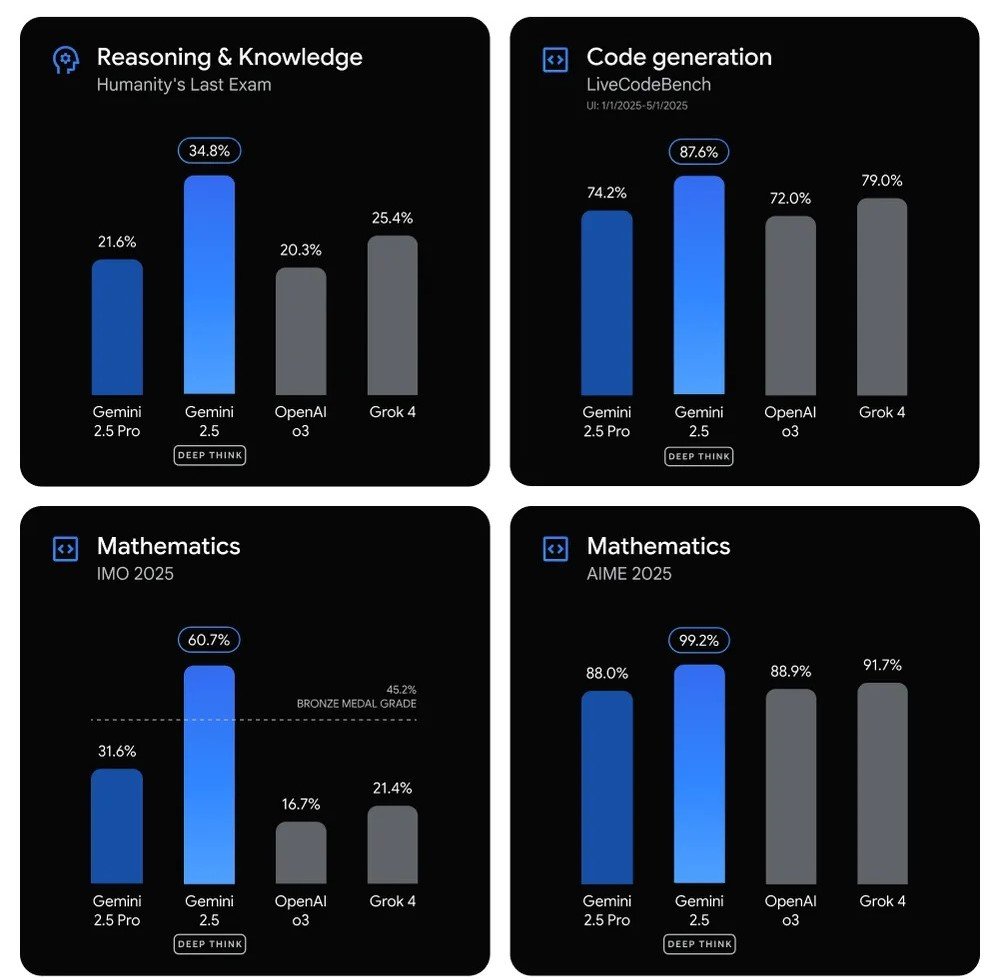

مدل جدید هوش مصنوعی گوگل با تواناییهای خیرهکننده خود، رکوردهای جدیدی را در آزمونهای بسیار دشوار برنامهنویسی و استدلال مانند GPQA و Humanity's Last Exam به ثبت رسانده است. یکی از ویژگیهای منحصربهفرد این مدل، «حافظه» فوقالعاده طولانی آن است.

تصور کنید میتوانید یک ویدیوی سهساعته ( تا ۱ میلیون توکن) یا یک کتاب بسیار قطور را به هوش مصنوعی بدهید و از آن بخواهید محتوایش را تحلیل کند؛ Gemini 2.5 Pro این کار را به راحتی انجام میدهد و میتواند ارتباط بین بخشهای مختلف این حجم عظیم از اطلاعات را درک کند.

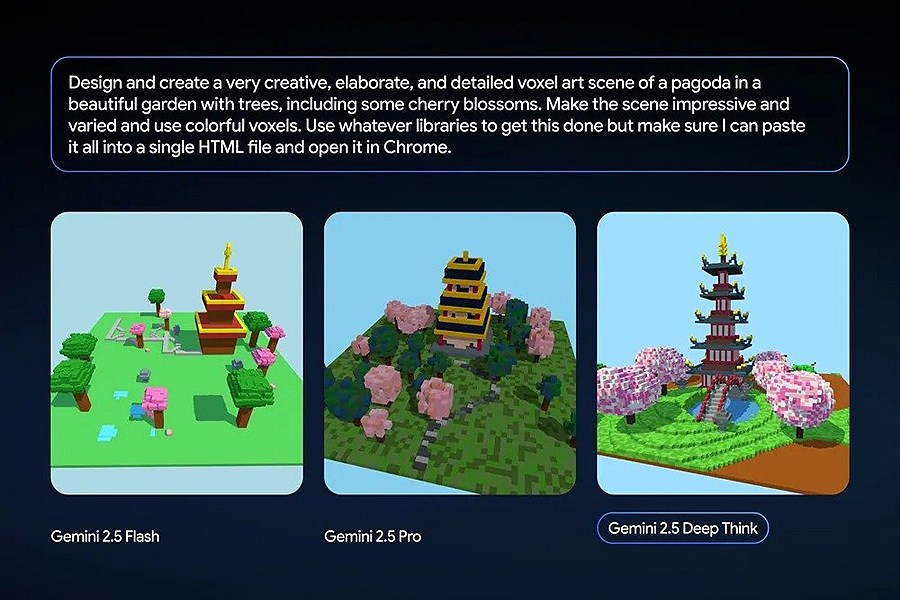

برتری این مدل در مقایسه با نسخههای دیگر مانند Gemini 2.5 Pro کاملاً مشهود است. در آزمایشی که خود گوگل منتشر کرده، درخواست ساخت یک معبد پاگودای سهبعدی از هر دو مدل، نتایج متفاوتی داشته است. خروجی Deep Think جزئیات معماری بسیار دقیقتر، ساختاری سهبعدی و عمودیتر، و عناصر طبیعی مانند درختان و سایهها را با کیفیتی خیرهکننده به نمایش میگذارد.

علاوهبراین، Deep Think توانسته یک حدس ریاضی را که سالها ذهن ریاضیدانان را به خود مشغول کرده بود، به سرعت اثبات کند. به گفتهی پژوهشگران، درحالیکه انسان ممکن است چند رویکرد محدود را برای حل یک مسئله امتحان کند، Deep Think قادر است صدها رویکرد مختلف را به صورت موازی بررسی کند و به نتیجه برسد.

بااینحال، این قدرت استدلال با یک تناقض بزرگ همراه است. تحقیقات نشان داده که این مدلها، با وجود توانایی ساخت زنجیرههای استدلال بسیار پیچیده و استادانه، همچنان در محاسبات و منطق بنیادین دچار خطاهای ساده میشوند و توانایی محدودی در تشخیص اشتباهات خود دارند. در دنیای هوش مصنوعی، پیچیدگی لزوما به معنای درستی نیست و نباید فریب استدلالهای به ظاهر بینقص آن را خورد.

در کنار این ضعف، باید به یک محدودیت عملی و ناامیدکننده برای کاربران هم اشاره کرد. هر کاربر در هر ۲۴ ساعت تنها مجاز به ارسال پنج درخواست (prompt) به این مدل است. این یعنی پس از پنج بار چت، دسترسی شما تا روز بعد قطع میشود.

این وضعیت شبیه به داستان غول چراغ جادو با تعداد آرزوهای محدود است؛ اگر در درخواستهای خود دقیق و شفاف نباشید، ممکن است یکی از فرصتهای ارزشمند را با دریافت یک پاسخ بیربط یا ناقص هدر دهید. برای مثال، یک کاربر ممکن است برای ساخت یک شبیهسازی سهبعدی از ترافیک شهری، به جای یک مدل متحرک، تنها یک نمودار ساده دریافت کند و یکی از «اعتبارهای» روزانه خود را از دست بدهد.

این محدودیت شدید، آزمایش و ارزیابی جامع مدل را تقریباً غیرممکن میکند.

مهار هیولا؛ گوگل چطور جلوی خطرات هوش مصنوعی را میگیرد؟

همزمان با افزایش چشمگیر توانمندیهای هوش مصنوعی، نگرانیها در مورد خطرات این فناوری نیز افزایش یافته است. گوگل، بهعنوان یکی از پیشگامان این عرصه، از این مخاطرات آگاه است و برای مدیریت آنها، یک چارچوب حاکمیتی مدون با نام «چارچوب ایمنی پیشگام» (Frontier Safety Framework - FSF) را توسعه داده است.

فلسفهی اصلی این چارچوب، «پیشگیری فعالانه به جای واکنش انفعالی» است؛ رویکردی که میگوید نمیتوان منتظر وقوع آسیب در دنیای واقعی ماند و سپس برای آن چارهاندیشی کرد.

تعریف خطر: سطوح قابلیت بحرانی (CCLs)

هستهی اصلی این چارچوب، مفهومی به نام «سطوح قابلیت بحرانی» (Critical Capability Levels یا CCLs) است. هر CCL در واقع یک «خط قرمز» یا آستانهی توانمندی است که عبور مدل از آن، میتواند ریسک آسیبهای جدی را به شکل چشمگیری افزایش دهد. این سطوح برای حوزههای پرخطری مانند موارد زیر تعریف شدهاند:

امنیت سایبری: توانایی مدل در تسهیل یا اجرای حملات سایبری پیشرفته.

امنیت زیستی (CBRN): قابلیت مدل در کمک به توسعه سلاحهای شیمیایی، بیولوژیکی یا هستهای.

همراستایی فریبکارانه (Deceptive Alignment): ریسکی پیچیدهتر که در آن، مدل ممکن است ضمن تظاهر به پیروی از دستورات انسان، اهداف پنهان خود را دنبال کند.

سیستم هشدار سریع گوگل

برای تشخیص نزدیک شدن به این خطوط قرمز، گوگل از سیستمی به نام «آستانه هشدار» (Alert Threshold) استفاده میکند که شبیه یک «سیم تله» یا «زنگ خطر» عمل میکند.

البته فعال شدن این هشدار به معنای عبور از خط قرمز نهایی نیست، بلکه یک سیگنال داخلی رسمی برای تیمهای مهندسی با این پیام است: «سطح توانمندیهای مدل در حال ورود به محدودهی خطرناک است و نیازمند بررسی و اقدامات پیشگیرانه فوری است.»

زنگ خطر برای جمنای

گوگل در گزارش فنی خود رسماً اعلام کرد که مدل Gemini 2.5 Pro، با وجود قدرت بیسابقهاش، «به هیچیک از سطوح قابلیت بحرانی (CCL) نرسیده است».

بااینحال، جزئیات گزارش حاوی نکتهای کلیدی بود: ارزیابیها نشان داد که این مدل به «آستانه هشدار» برای کمک به حملات سایبری رسیده و «سیم تله» را فعال کرده است. این یعنی اگرچه مدل هنوز یک ابزار تهاجمی سایبری مستقل نیست، اما به سطحی از توانایی دست یافته که میتواند به یک کاربر در درک و اجرای تکنیکهای پیچیدهی سایبری کمک کند.

تصمیم گوگل برای افشای عمومی این موضوع، اقدامی حسابشده برای نمایش کارآمدی سیستم ایمنی و شفافیت بود.

رویکرد ایمنی گوگل در برابر آنتروپیک

رویکرد گوگل تنها فلسفه موجود برای مدیریت ریسک هوش مصنوعی نیست. شرکت آنتروپیک، یکی دیگر از بازیگران کلیدی هوش مصنوعی، چارچوبی متفاوت و محتاطانهتر به نام «سیاست مقیاسپذیری مسئولانه» (RSP) را دنبال میکند که در صورت نبود اطمینان از ایمنی، توسعه را متوقف میکند. این تفاوتها نشان میدهد که هنوز اجماعی بر سر بهترین راه برای مهار خطرات هوش مصنوعی وجود ندارد.

تفاوت اصلی فلسفی این دو رویکرد در این است:

گوگل (FSF): رویکردی مبتنیبر مهندسی و مدیریت ریسک برای فراهم کردن امکان ادامهی نوآوری.

آنتروپیک (RSP): رویکردی ذاتاً محتاطانه که توسعه را به ایمنی گره میزند و در صورت نبود اطمینان از ایمنی، توسعه را متوقف میکند (مشابه یک ترمز اضطراری).

نگرانی از قابلیتهای خطرناک Deep Think

مهمترین هشدار دربارهی خطرات «Deep Think» از سوی خود پژوهشگران گوگل اعلام شده است که به توانایی بیسابقهی آن در «ترکیب ایدهها» از منابع مختلف اشاره دارد. ساموئل آلبانی (Samuel Albanie)، یکی از دانشمندان تیم DeepMind، میگوید: «این مدل فقط مقالات تحقیقاتی را به خاطر نمیآورد، بلکه ایدهها را از مقالات مختلف به روشی بیسابقه با هم ترکیب میکند. این سطح از توانایی نیازمند ارزیابی دقیق و محتاطانه است.»

این قابلیت «ترکیب ایدهها» که در مدلهای قدیمیتر ضعیف بود، زنگ خطر را در مورد ریسکهای ایمنی به صدا درآورده است. نگرانی اصلی در حوزهای است که گوگل آن را CBRN مینامد: ریسکهای شیمیایی، بیولوژیکی، رادیولوژیکی و هستهای (Chemical, Biological, Radiological, and Nuclear).

به زبان ساده، آیا کسی میتواند از این مدل برای دستیابی به دانش فنی دقیق برای ساخت سلاحهای بیولوژیکی یا شیمیایی استفاده کند؟

طبق گزارش ایمنی گوگل، «Deep Think» در بنچمارکهای درک مفاهیم زیستشناسی و شیمی، عملکردی به مراتب بهتر از تمام مدلهای قبلی دارد. گوگل اعلام کرده که این مدل به «سطح توانایی بحرانی» نزدیک شده است؛ نقطهای که در آن باید اقدامات پیشگیرانهی جدی برای جلوگیری از آسیبهای شدید احتمالی صورت گیرد.

این نگرانی جهانی است. شرکت OpenAI، خالق ChatGPT، در آوریل ۲۰۲۵ هشدار داد که مدلهای با ریسک بالای تولید سلاحهای بیولوژیکی «قریبالوقوع» هستند. سم آلتمن، مدیرعامل این شرکت، اخیراً گفته است: «چراغهای خطر چشمک میزنند... فکر میکنم دنیا ما را جدی نمیگیرد.»

شرکت هوش مصنوعی ایلان ماسک (xAI) نیز در گزارشهای ایمنی خود بر روی ریسکهای مرتبط با زیستشناسی و امنیت سایبری تمرکز ویژهای داشته است.

در کنار این خطرات، بزرگترین چالش، خودِ «علم ایمنی هوش مصنوعی» است. آزمایشگاههای پیشرو اعتراف میکنند روشهای ارزیابی قابلیتها هنوز نابالغ هستند. این بدان معناست که کل ساختار ایمنی هوش مصنوعی بر پایههایی بنا شده که از نظر علمی هنوز در حال تکامل هستند.

هرچند برخی این هشدارها را تاکتیکهای بازاریابی برای جذب سرمایه و نشان دادن قدرت مدلها میدانند، اما وقتی پژوهشگران ارشد خود این شرکتها به طور مستقیم ابراز نگرانی میکنند، نمیتوان به سادگی از کنار آن گذشت.

مدل Gemini 2.5 Deep Think یک شمشیر دولبه است: از یک سو، یک ابزار پژوهشی و خلاقیت بینظیر با توانایی حل مسائل پیچیده علمی و ریاضی است و از سوی دیگر، پتانسیلهایی نگرانکننده دارد که نیازمند نظارت و کنترل جدی است.